„Vornehmliches Einsatzgebiet von Deepfake-Videos ist deren Verwendung für kriminelle Zwecke, insbesondere bei der Erstellung nicht einvernehmlicher Pornografie.”

Gefährliche Illusionen

Fast jede*r von uns kommt regelmäßig mit Bildern und Videos aus dem Internet in Berührung. Dabei stellen wir uns nur selten die Frage, ob das, was zu sehen ist, überhaupt der Realität entspricht. Ein Fehler, der wegen sogenannten Deepfakes zunehmend gefährlicher wird. Bei Deepfakes handelt es sich um Medienformate – vornehmlich Bilder und Videos –, die mithilfe von Künstlicher Intelligenz (KI) manipuliert wurden. Das Gesicht einer Person kann dadurch ganz einfach durch das Gesicht einer anderen ersetzt werden und zwar ohne, dass es den Zuschauer*innen auffällt. Auf einmal wird Olaf Scholz über Unterwäsche reden, Promis in pornographischen Filmen auftreten oder das eigene Gesicht bei populistischen Veranstaltungen zu sehen sein.

Professor Dr. Andreas Koch doziert an der Hochschule der Medien Stuttgart und ist u.a. Experte auf dem Gebiet der Künstlichen Intelligenz. Er betont, dass ein solcher Deepfake mittlerweile in kürzester Zeit erstellt werden kann und dass wir alle Ziele dieser visuellen Manipulation werden können.

Eine durchaus düstere und geradezu beängstigende Vorstellung, trotzdem bergen der Deepfake und vor allem die daraus weiterentwickelten Technologien auch einige Vorteile. So benutzte zum Beispiel die Band Lindemann KI-basierte Bilderstellung, um ein ganzes Musikvideo entstehen zu lassen („Ich weiß es nicht“ aus dem Album “F&M”). Die Plattform MyHeritage bot ihren User*innen eine Funktion an, mit deren Hilfe man die Fotos von verstorbenen Familienmitgliedern wieder zum Leben erwecken konnte. Veröffentlichte Videos, welche die Reaktionen von Menschen zeigten, denen ihre verstorbenen Eltern, Geschwister und Großeltern auf Fotos zulächelten, gingen auf sozialen Netzwerken viral. Schließlich nutzten Schauspieler wie Bruce Willis (bekannt u.a. aus Stirb Langsam und 12 Monkeys) die Vorteile der Technologie. Willis ließ für den Werbespot eines russischen Telekommunikationsunternehmens einen Deepfake von sich erstellen. Das Ergebnis: Er taucht in dem Film als eine der Hauptrollen auf, ohne jemals am Drehort erschienen zu sein.

Wo Licht ist, da ist meist auch Schatten. Dabei bildet der Deepfake keine Ausnahme. Schon bei einem der ersten offiziell veröffentlichten Deepfake-Videos, handelte es sich um pornographische Szenen, in denen die Gesichter von prominenten Persönlichkeiten auf die der Darsteller*innen gesetzt wurden. Es steht stellvertretend für die Gefahren, die eine solche Technologie mit sich bringt. Denn theoretisch macht es der Deepfake nahezu unmöglich Bildern oder Videos im Internet zu vertrauen. Immerhin kann jede Rede eines Politikers und einer Politikerin, jeder Auftritt eines Künstlers und einer Künstlerin, jedes einzelne Bild, das einen Menschen zeigt, künstlich generiert worden sein. Gerade in Zeiten von wachsender Unsicherheit im Netz, Fake-News-Wellen und korrumpierter Berichterstattung, gießen derlei Technologien Öl in ein Feuer, das zunehmend gefährlicher wird.

Was kann ich als Mediennutzer*in beachten?

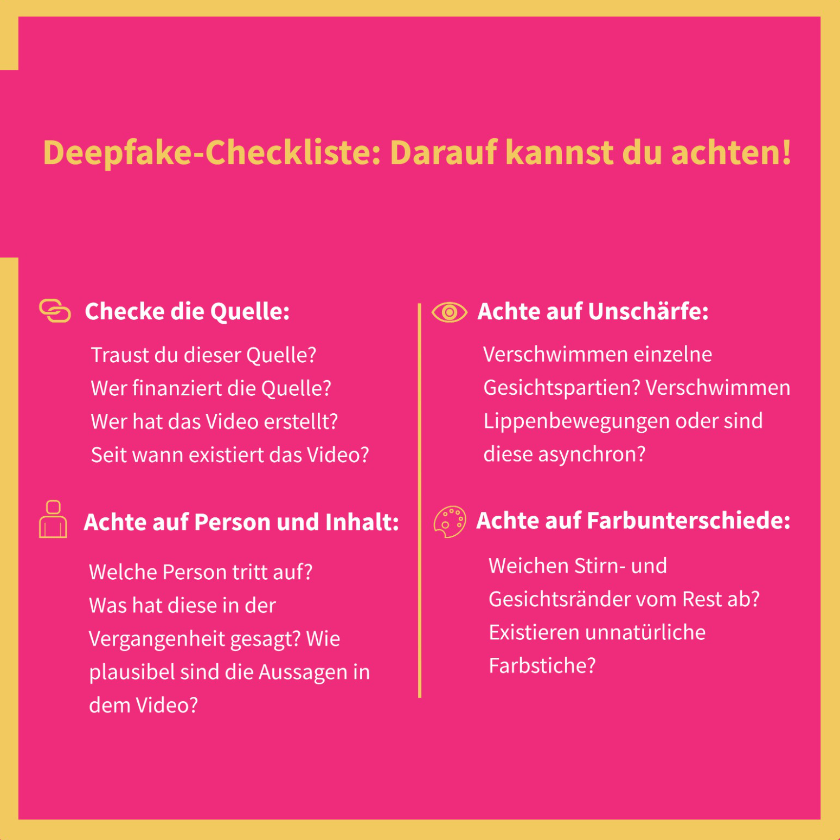

Unterm Strich machen es Deepfakes und daraus weiterentwickelte Technologien fast unmöglich, Videomaterial im Internet zu vertrauen. Grund dafür ist auch eine fehlende Gesetzesgrundlage, um die böswillige Erstellung solcher Videos zu verbieten. Als Nutzer*in von sozialen Medien und audiovisuellen Medien im Allgemeinen muss man sich dieser Gefahr dringend bewusst werden. In erster Linie greifen dabei dieselben Prinzipien, die auch in Verbindung mit potenziellen Fake-News nützlich sind. Es ist wichtig, den Inhalt von Videos, Bildern, aber auch von Informationen im Allgemeinen, plattformunabhängig zu hinterfragen. Wenn abstruse Behauptungen aufgestellt, extreme Meinungen vertreten und ungewöhnliche Äußerungen gemacht werden, kann es sich um einen Deepfake oder Fake-News handeln. Auch die Quelle des Bildmaterials kann ein Indikator für Desinformation und Fälschung sein. Schließlich steht die Frage im Raum, ob sich das Material überprüfen lässt, bzw. ob andere Distributoren – seien das journalistische Medien, Videoplattformen oder einzelne Persönlichkeiten – die Inhalte ebenfalls verbreiten und als wahr deklarieren. Aber auch am Bildmaterial selbst gibt es Details, mit Hilfe derer sich Deepfakes enttarnen lassen. Zum einen gilt es, auf Konturen des abgebildeten Gesichts zu achten. Verschwimmen diese, sollte man misstrauisch werden. Zum anderen sind in der Bewegung unscharf werdende Linien und Umrisse ein wichtiges Warnsignal, ebenso farbliche Abweichungen an den Gesichtsrändern. Im Internet existieren mehrere Möglichkeiten, um zu überprüfen, wie gut du Deepfakes erkennst. Einen kostenlosen Test stellt dir zum Beispiel die österreichische Tageszeitung Der Standard zur Verfügung.

Deepfakes bergen weitreichende Gefahren, die allerdings weniger von der Technologie an sich herrühren, als vielmehr von menschlichen Akteur*innen ausgehen, die sich gesetzliche Lücken zu Nutze machen. Sie nutzen diese Schwachstellen, um Meinungen zu steuern und gezielt Falschinformationen zu verbreiten. Solange der Staat nicht eingreift, erscheint es deswegen umso wichtiger, dass Menschen einen vorsichtigen und vor allem kritischen Umgang mit den Medien erlernen. Denn wenn uns der Deepfake eines gelehrt hat, dann, dass manchmal nichts so ist, wie es scheint!